Die Schweizer Plattformregulierung und der EU Digital Services Act

Ein Überblick

Diese Analyse vergleicht in Kürze den Vorentwurf für das Bundesgesetz über Kommunikationsplattformen und Suchmaschinen mit dem EU Digital Services Act, im Hinblick auf den Geltungsbereich, die Pflichten, sowie die Aufsicht und Sanktionen.

Executive Summary

Der Bundesrat hat am 29. Oktober 2025 den Vorentwurf für das Bundesgesetz über Kommunikationsplattformen und Suchmaschinen (“Entwurf”) veröffentlicht und in die Vernehmlassung geschickt. Der erläuternde Bericht betont, dass sich der Entwurf inhaltlich eng am Digital Services Act (DSA) der Europäischen Union orientiert.

Diese Analyse vergleicht in Kürze den Entwurf mit dem DSA, im Hinblick auf den Geltungsbereich, die Pflichten, sowie die Aufsicht und Sanktionen.

-

Geltungsbereich: Der Entwurf fokussiert auf grosse Kommunikationsplattformen und Suchmaschinen, der DSA erfasst auch kleine Plattformen und E-Commerce Plattformen.

-

Pflichten: Der Entwurf übernimmt einen Grossteil der Pflichten des DSA, mitunter bezüglich der Meldung und Entfernung von Inhalten, den Mechanismen für Beschwerden und Streitbeilegung, der Transparenz, des Umgangs mit Risiken und der Governance. Diese Pflichten sind teils anders ausgestaltet und im DSA meistens detaillierter und umfassender dargelegt. Der DSA enthält aber auch weitere Pflichten, zum Schutz von Minderjährigen, zum Vorgehen gegen rechtswidrige Inhalte und zur Minderung von Risiken.

-

Aufsicht und Sanktionen: Die zuständigen Behörden sind strukturell anders. Die Sanktionen für Pflichtverstösse sind analog und die Kostentragung ähnlich. Der DSA kennt zudem tägliche Zwangsgelder, um die Verfahrensteilnahme zu sichern.

Ziel dieser Analyse ist es, verschiedene Stakeholder in der Vernehmlassung zu unterstützen, die bis zum 16. Februar 2025 dauert. Die Erkenntnisse basieren auf unserem Tool, das den Vergleich des Entwurfs mit dem DSA erleichtert. Darin findet sich auch eine konsolidierte Version, die für jeden Artikel des Entwurfs die relevante Passage des erläuternden Berichts aufzeigt. In Kürze veröffentlichen wir weitere Analysen und organisieren Events, im Rahmen unseres Projekts für einen breiten Diskurs zur Plattformregulierung. Wir danken der Stiftung Mercator Schweiz und der Law and Economics Foundation St. Gallen für die Unterstützung.

Der Entwurf erfasst grosse Kommunikationsplattformen und Suchmaschinen,

-

die Dienste in der Schweiz anbieten, unabhängig von ihrem Sitz,

-

deren Hauptzweck darin besteht, von Nutzer:innen (nachfolgend “Nutzer”) erstellte Inhalte öffentlich zugänglich zu machen und

-

deren Dienste durchschnittlich von mindestens 10% der Schweizer Bevölkerung einmal pro Monat genutzt werden.

Der DSA erfasst alle Anbieter:innen (nachfolgend “Anbieter”) von Vermittlungsdiensten für Nutzer in der Europäischen Union, unabhängig von ihrer Niederlassung. Allgemeine Pflichten gelten für alle Vermittlungsdienste, einschliesslich reiner Durchleitung, Caching und Hosting. Eine aufbauende Kaskade von weiteren Pflichten gilt für

-

Hostingdienste,

-

Online-Plattformen, einer Spezialform von Hostingdiensten, und

-

sehr grosse Online-Plattformen oder Suchmaschinen, mit mindestens 45 Millionen monatlichen Nutzenden in der EU, welche die Europäische Kommission bezeichnet.

Hinzu kommen spezifische Regeln für Online-Plattformen, die Nutzern den Abschluss von Fernabsatzverträgen mit Unternehmern ermöglichen ("Online-Marktplätze").

Der Entwurf betrifft somit nur einen Teil aller Vermittlungsdienste. Der Schwellenwert für “grosse” Plattformen entspricht grob jenem der “sehr grossen Online-Plattformen oder Suchmaschinen” im DSA, da 45 Millionen in etwa 10% der Unionsbevölkerung entsprechen. Kleinere Plattformen und E-Commerce Plattformen sind bewusst nicht erfasst.

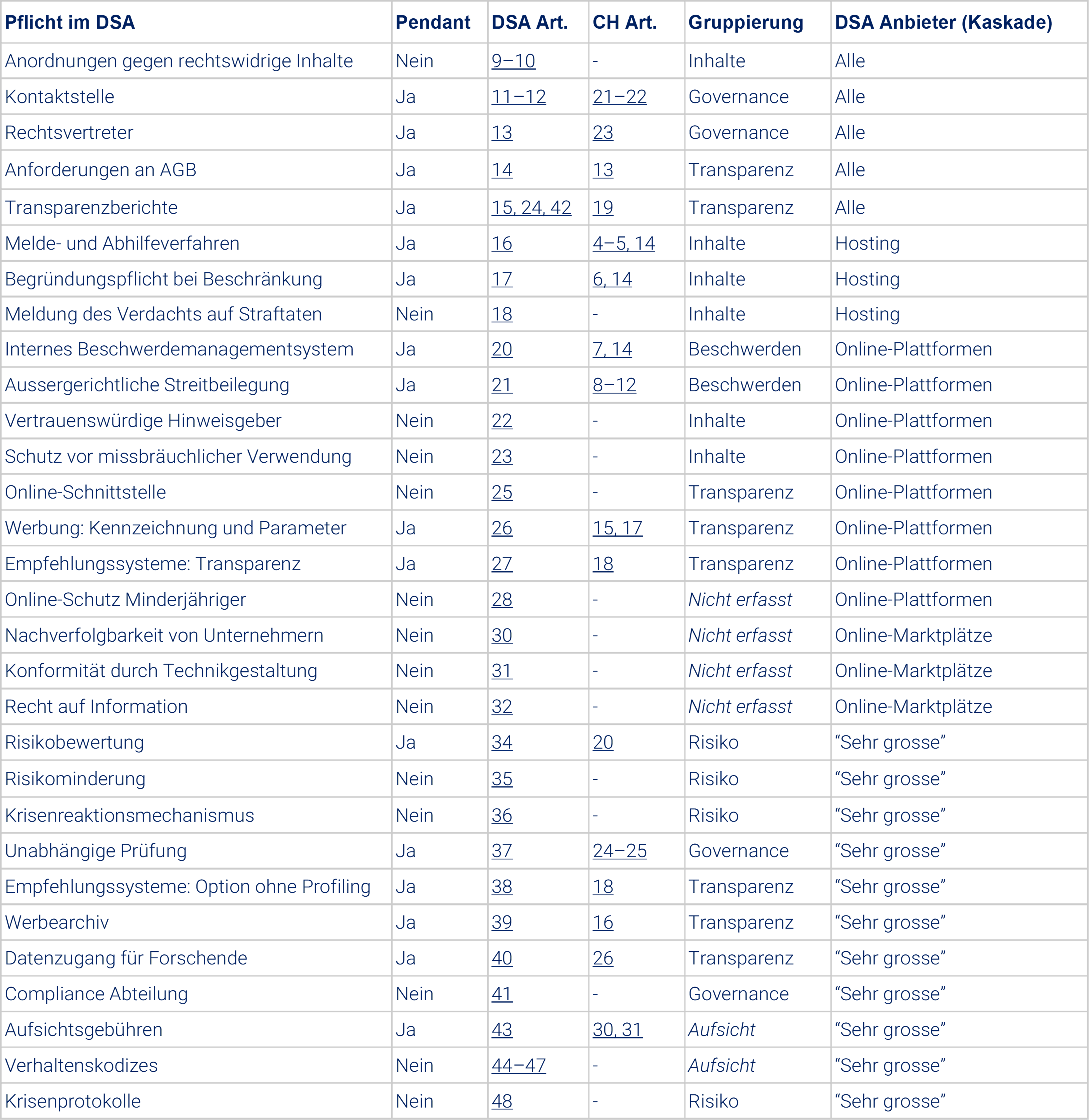

Um die Pflichten zu vergleichen, führen wir zunächst alle Pflichten im DSA auf und suchen für jede Pflicht ein “Pendant” im Entwurf. Pendants belegen lediglich das Vorhandensein einer ähnlichen Pflicht in beiden Regelwerken – wir stellen diese Pflichten nicht gleich. Die folgende Tabelle liefert eine Übersicht dieser Pendants, mit Verweisen auf relevante Artikel in beiden Regelwerken, sowie die Kaskade der betroffenen Anbieter im DSA. Nachfolgend spezifizieren wir nicht mehr, für welche Anbieter im DSA welche Pflichten gelten, da “sehr grosse Online-Plattformen oder Suchmaschinen” grundsätzlich allen Pflichten unterstehen und in der Schweiz im Fokus liegen.

Danach skizzieren wir, welche Pflichten der Entwurf direkt übernimmt, wie diese Pflichten in beiden Regelwerken anders ausgestaltet sind, und welche Pflichten nur im DSA vorliegen und im Entwurf nicht. Wir bauen dabei Einblicke in die Umsetzung und Durchsetzung des DSA aus der Digital Policy Alert Datenbank ein. Als Struktur bilden wir fünf Gruppen von Pflichten: Meldung und Entfernung von Inhalten, Beschwerden und Streitbeilegung, Transparenz, Umgang mit Risiken und Governance.

Der Entwurf nimmt drei Kernelemente des DSA zur Meldung und Entfernung von Inhalten auf:

-

Anbieter müssen Nutzern ein Verfahren zur Meldung rechtswidriger Inhalte bereitstellen. Nutzer müssen mindestens Gewaltdarstellungen, Verleumdung, Beschimpfung, Drohung, Nötigung, sexuelle Belästigung, öffentliche Aufforderung zu Verbrechen und Diskriminierung und Aufruf zu Hass melden können. Aus der Sorgfaltspflicht ergibt sich, dass das Verfahren elektronisch verfügbar, leicht zugänglich und benutzerfreundlich ausgestaltet sein muss.

-

Anbieter müssen Meldungen prüfen und zeitnah über einschränkende Massnahmen entscheiden, wobei keine Pflicht zur Entfernung gemeldeter Inhalte besteht. Als einschränkende Massnahmen gelten die Entfernung oder Herabstufung von Inhalten, die Einschränkung der Monetarisierungsmöglichkeiten, der Ausschluss von Nutzern von Dienstleistungen sowie die vorübergehende Sperrung oder Löschung von Nutzerkonten. Die Sorgfaltspflicht verlangt, dass Anbieter ohne Willkür und Diskriminierung vorgehen.

-

Anbieter haben eine Mitteilungspflicht gegenüber Nutzern, die von einschränkenden Massnahmen betroffen sind. Unter Beachtung der Sorgfaltspflicht muss die Mitteilung die Gründe für die Massnahme enthalten, den Einsatz automatisierter Mittel angeben und auf den Mechanismus für Beschwerden und aussergerichtliche Streitbeilegungsstelle verweisen.

Diese Pflichten orientieren sich stark am DSA, sind allerdings nicht identisch. Das Meldeverfahren im DSA enthält keine Liste rechtswidriger Inhalte und führt das Konzept von “vertrauenswürdigen Hinweisgebern” ein, deren Meldungen vorrangig zu behandeln sind. Auch gilt im DSA eine hinreichend genaue und begründete Meldung eines rechtswidrigen Inhaltes explizit als Kenntnis darüber, wodurch Anbieter haften. Die einschränkenden Massnahmen sind im DSA hingegen dieselben, wobei Anbieter ebenso sorgfältig, objektiv und verhältnismässig vorgehen und Grundrechte wahren müssen. Die Begründungspflicht im DSA ist detaillierter und umfassender.

Letztlich erstellt der DSA Pflichten, die im Entwurf nicht enthalten sind. Erhalten Anbieter eine behördliche Anordnung zur Entfernung rechtswidriger Inhalte, müssen sie unverzüglich angeben, ob und wie sie diese umsetzen sowie die relevanten Behörden und Nutzer informieren. Zudem müssen Anbieter Behörden benachrichtigen, wenn sie Kenntnis von einer mutmasslichen Straftat erlangen, die eine Gefahr für das Leben oder die Sicherheit von Personen darstellt. Des Weiteren sieht der DSA zum Missbrauchsschutz vor, dass Anbieter die Erbringung ihrer Dienste für Nutzer, die häufig und offensichtlich rechtswidrige Inhalte bereitstellen, für einen angemessenen Zeitraum nach vorheriger Warnung auszusetzen haben. Ebenso haben Anbieter die Bearbeitung von Meldungen für eine angemessene Dauer auszusetzen, wenn Personen oder Stellen wiederholt und offensichtlich unbegründete Meldungen machen.

Seit Inkrafttreten des DSA laufen mehrere Untersuchungen zu diesen Pflichten. Die Europäische Kommission hat vorläufig festgestellt, dass das Meldeverfahren von Meta unzureichend ist, Verpflichtungszusagen zur Verbesserung des Meldeverfahrens durch AliExpress erhalten und Informationen zum Meldeverfahren von Shein verlangt. Letztlich wurden freiwillige Verhaltenskodexe zur Bekämpfung illegaler Hetze und Desinformation in den DSA integriert.

Der Entwurf übernimmt den zweistufigen Mechanismus des DSA zur Anfechtung von Moderationsentscheidungen: Nutzer müssen ein kostenloses internes Beschwerdeverfahren einleiten können und Zugang zu einer aussergerichtlichen Streitbeilegungsstelle erhalten.

-

Für die Einreichung einer Beschwerde gilt eine Frist von mindestens 6 Monaten. Die Bearbeitung hat sodann zeitnah zu erfolgen. Dafür ist der unterstützende Einsatz automatisierter Systeme zulässig, unter Aufsicht von qualifiziertem Personal. Der Entscheid des Verfahrens ist für nachfolgende Verfahren nicht bindend.

-

In der Streitbeilegung prüft eine externe Stelle die Moderationsentscheidungen von Anbietern niederschwellig, kostengünstig und rasch. Dies erfolgt parallel zu anderen Überprüfungsmechanismen und schliesst solche nicht aus. Anbieter müssen grundsätzlich teilnehmen und die Verfahrenskosten unabhängig vom Ausgang des Verfahrens tragen, ausser Nutzer handeln böswillig. Streitbeilegungsstellen werden vom Bundesamt für Kommunikation auf Antrag zugelassen und müssen jährlich Bericht erstatten.

Der DSA schreibt einen ähnlichen zweistufigen Mechanismus vor, der genauer beschrieben ist.[1] Zudem sieht der DSA zum Missbrauchsschutz vor, dass Anbieter die Bearbeitung von Beschwerden für eine angemessene Dauer aussetzen, wenn Personen oder Stellen wiederholt und offensichtlich unbegründete Eingaben machen.

Seit Inkrafttreten des DSA wurden acht aussergerichtliche Streitbeilegungsstellen zugelassen. Das im Oktober 2024 lancierte Appeals Center Europe, die erste anerkannte Stelle, hat zwischen November 2024 und August 2025 fast 10’000 Anfragen geprüft. Rund 3’300 fielen in den Anwendungsbereich und in ca. 75% dieser Fälle wurde die ursprüngliche Entscheidung der Plattform aufgehoben.

Des Weiteren führt die Europäische Kommission mehrere Untersuchungen zu diesen Pflichten. Die Kommission hat vorläufig festgestellt, dass das interne Beschwerdemanagement von Meta unzureichend sei, wegen ungenügend nutzerfreundlichen Verfahren für Beschwerden . Die Kommission hat auch Verpflichtungszusagen von AliExpress angenommen, mitunter um das interne Beschwerdemanagementsystem zu stärken.

Der Entwurf adoptiert eine Reihe von Transparenzpflichten aus dem DSA, namentlich

-

die Anforderungen an Allgemeine Geschäftsbedingungen (AGB),

-

die Erstellung jährlicher Transparenzberichten,

-

die Kennzeichnung von Werbung und Einrichtung eines Werbearchivs,

-

die Offenlegung der Funktionsweise von Empfehlungssystemen und Möglichkeit einer Option ohne Profiling,

-

die Möglichkeit für Nutzer, eigene kommerzielle Inhalte offenzulegen, und

-

den Zugang zu Daten.

Der DSA ist grundsätzlich detaillierter in der Darlegung dieser Pflichten und verlangt teils weitergehende Transparenz. Beispielsweise verlangen beide Regelwerke, dass die AGB in Amtssprachen verfügbar sind und Nutzer über Änderungen informiert werden. Der DSA nimmt bei den AGB darüber hinaus konkret Bezug auf Grundrechte und verlangt zusätzliche Transparenz, wenn Dienste durch Minderjährige genutzt werden. Beim Datenzugang hingegen erwähnt der Entwurf, im Gegensatz zum DSA, explizit auch zivilgesellschaftliche Akteure. Eine Pflicht, die im DSA besteht, aber im Entwurf nicht, ist dagegen die Einrichtung einer zentralen Online-Schnittstelle, die sämtliche Transparenz- und Informationspflichten bündelt.

Seit Inkrafttreten des DSA sind die Transparenzbestimmungen im Fokus der Europäischen Kommission. Sie hat eine Durchführungsverordnung mit Vorlagen zur Berichterstattung veröffentlicht, die DSA Transparenz- und AGB-Datenbank lanciert sowie ein Europäisches Zentrum für die Transparenz der Algorithmen erschaffen. Kürzlich ist zudem die delegierte Verordnung zum Datenzugang in Kraft getreten. Die Anbieter veröffentlichen die Transparenzberichte halbjährlich und die letzten Berichte sind im Sommer 2025 erschienen (siehe Google Search, Meta, und TikTok).

Die Kommission führt auch mehrere Untersuchungen zu den Transparenzpflichten:

-

Beim Datenzugang stellte die Kommission vorläufig fest, dass TikTok Forschenden durch aufwändige Verfahren nur eingeschränkt oder unzuverlässig Daten bereitstelle und Meta ebenso durch komplexe Abläufe unvollständige Daten liefere. Die Kommission hat auch schon von 17 Anbietern umfangreiche Informationen zum Datenzugang gefordert.

-

Im Bereich der Werbetransparenz stellte die Kommission vorläufig fest, dass das Werbearchiv von TikTok ungenügend sei, wegen unvollständigen Angaben zu Inhalten, Kriterien und Sponsoren. Zusätzlich forderte die Kommission Informationen von Apple zur Transparenz von Werbesystemen. Klagen von Amazon, Aylo, NKL und XVideos gegen die Einrichtung eines Werbearchiv scheiterten vor dem Europäischen Gerichtshof.

-

Bezüglich der Empfehlungssysteme, hat die Kommission X angeordnet, Informationen zu geplanten Änderungen zu sichern und von Apple, Meta, Google, Youtube und Snapchat Informationen zu deren Transparenz und Funktionsweise gefordert. Ausserdem hat sich AliExpress verpflichtet, das Empfehlungssystem benutzerfreundlich personalisierbar zu gestalten und in den AGB leicht zugängliche Informationen dazu zur Verfügung zu stellen.

Der Entwurf übernimmt vom DSA die Pflicht für Anbieter, jährlich eine Bewertung der Risiken vorzunehmen, die sich aus ihren Dienste ergeben können. Ein Bericht hat umfassend über die systemischen Risiken in der Schweiz Auskunft zu geben, mitunter die Verbreitung von rechtswidrigen Inhalten, die nachteiligen Auswirkungen auf die Ausübung von Grundrechten und die negativen Folgen für die öffentliche Meinungsbildung, Wahl- und Abstimmungsprozesse, sowie die öffentliche Sicherheit, Ordnung und Gesundheit. Der DSA sieht eine ähnliche Risikobewertung vor, die detaillierter formuliert ist und explizit nachteilige Auswirkungen im Hinblick auf geschlechtsspezifische Gewalt und Minderjährige umfasst.

Der DSA kennt darüber hinaus die Pflicht, angemessene, verhältnismässige und wirksame Massnahmen zur Minderung dieser Risiken zu ergreifen. Der Entwurf kennt diese Pflicht nicht: Der erläuternde Bericht betont, dass keine Pflicht zur Ergreifung von Massnahmen zur Risikominderung besteht.

Der DSA sieht des Weiteren einen Mechanismus für die Reaktion auf Krisen vor. Die Europäische Kommission kann, im Falle einer schwerwiegenden Bedrohung der öffentlichen Sicherheit oder Gesundheit verbindliche Massnahmen anordnen, unter anderem zur Bewertung und Begrenzung des Beitrags zur Krise, zur Umsetzung gezielter Minderungsmassnahmen sowie zur regelmässigen Berichterstattung über deren Wirksamkeit. Des Weiteren ermöglichen sogenannte Krisenprotokolle die koordinierte Bewältigung von aussergewöhnlichen Krisensituationen.

Die Europäische Kommission hat die Risikobewertung in mehreren Untersuchungen thematisiert:

-

Die Kommission hat ein Verfahren gegen TikTok bezüglich der Bewertung und Minderung von Risiken zur Integrität von Wahlen eröffnet. Zuvor hatte die Kommission verlangt, dass TikTok Informationen zur Bewertung und Minderung von Risiken im Zusammenhang mit den rumänischen Präsidentschaftswahlen sichert. Im Zentrum standen dabei Risiken bezüglich externer Einflussnahme und Empfehlungssystemen.

-

Die Kommission hat vorläufig festgestellt, dass Temu systemische Risiken im Zusammenhang mit dem Vertrieb illegaler Produkte unzureichend bewertet und gemindert habe.

-

AliExpress hat sich freiwillig verpflichtet, die interne Risikobewertung zu verbessern.

-

Die Kommission hat Informationen von Amazon, Apple, Google, Meta und Shein zu ihren Risikobewertungen und ergriffenen Massnahmen zu deren Minderung gefordert.

Des Weiteren veröffentlichen Anbieter mindestens jährlich Berichte zur Risikobewertung (siehe Google Search, Meta und TikTok). Die Kommission hat auch eine Leitlinie zur Minderung von systemischen Risiken im Zusammenhang mit Wahlen verabschiedet.

Der Entwurf nimmt im Bereich Governance drei Elemente des DSA auf:

-

Anbieter müssen eine leicht zugängliche Kontaktstelle für Nutzer und Behörden einrichten. Diese Kontaktstelle ermöglicht eine elektronische Kommunikation und ist barrierefrei zu gestalten.

-

Anbieter müssen einen Rechtsvertreter benennen, der als Zustellungsdomizil fungiert.

-

Anbieter müssen jährlich eine unabhängige Evaluation durchführen, um die Umsetzung der gesetzlichen Anforderungen zu überprüfen. Festgestellte Mängel sind im Sinne einer Nachbesserungspflicht zu beheben.

Der DSA sieht analoge Pflichten vor, geht jedoch im Hinblick auf den Rechtsvertreter weiter. Vertreter müssen über eine ausdrückliche Bevollmächtigung, ausreichende Befugnisse und Ressourcen verfügen, um behördlichen Entscheidungen nachzukommen. Der DSA sieht auch eine Haftung des Vertreters vor und verlangt die Einrichtung einer unabhängigen, internen Compliance-Abteilung.

Seit Inkrafttreten des DSA hat die Europäische Kommission eine delegierte Verordnung zur unabhängigen Prüfung erlassen. Anbieter haben des Weiteren erste Prüfungen veröffentlicht (siehe X, Meta, und TikTok).

Letztlich ist anzumerken, dass der Entwurf keine spezifischen Pflichten zum Schutz von Kindern vorsieht. Der DSA verlangt hingegen von Anbietern von Online-Plattformen, die für Minderjährige zugänglich sind, geeignete und verhältnismässige Schutzmassnahmen bezüglich der Privatsphäre, Sicherheit und Rechte von Minderjährigen. Der DSA untersagt auch personalisierte Werbung auf Grundlage von Profiling bei hinreichender Gewissheit, dass die betroffene Person minderjährig ist. Darüber hinaus verlangt der DSA, dass die AGB von Diensten für Minderjährige entsprechend verständlich gestaltet sind.

Seit Inkrafttreten des DSA hat die Europäische Kommission eine Leitlinie zum Schutz von Minderjährigen erlassen. Die Thematik liegt im Kern der Untersuchung gegen XVideos und steht dem Verfahren gegen TikTok, nebst anderen Pflichten, zugrunde.

Um die Aufsicht und Sanktionen gegenüberzustellen, analysieren wir die zuständigen Behörden, die Verfahrensschritte und Sanktionen sowie die Mechanismen zur Kostendeckung zusammen.

Die zuständigen Behörden sind aufgrund struktureller Unterschiede anders gestaltet:

-

Der Entwurf bezeichnet das Bundesamt für Kommunikation (BAKOM) als zuständige Aufsichtsbehörde. Das BAKOM ist für die Ausführungsbestimmungen verantwortlich und befugt, Verfügungen zu erlassen. Das BAKOM kontaktiert Anbieter, von denen es annimmt, dass sie die Schwellenwerte erfüllen, um Auskunft über die Anzahl Nutzer zu erhalten. Das BAKOM veröffentlicht auch eine Liste der betroffenen Anbieter.

-

Die Aufsicht des DSA ist ein Zusammenspiel zwischen nationalen Koordinatoren für digitale Dienste und der Europäischen Kommission, die für die Aufsicht und Durchsetzung von sehr grossen Online-Plattformen und Suchmaschinen zuständig ist. Die Kommission bezeichnet solche Anbieter und hat sodann Ermittlungs- und Sanktionsbefugnisse.

Die Verfahrensschritte und Sanktionen gegenüber Anbietern grosser Plattformen sind ähnlich:

-

Stellt das BAKOM eine Rechtsverletzung fest, kann es Anbieter dazu verpflichten, die Verletzung zu beheben, Präventionsmassnahmen zu ergreifen und über deren Umsetzung zu berichten. Erweisen sich die Massnahmen als unwirksam oder bestehen Zweifel daran, kann das BAKOM den Zugang zu Diensten vorübergehend einschränken. Bei geringen Verstössen kann das BAKOM Verwaltungssanktionen bis zu 1% des weltweiten Jahresumsatzes verhängen, bei schweren oder wiederholten Verstössen bis zu 6%.

-

Bei Verdacht eines Verstosses kann die Kommission eine Untersuchung einleiten, um Auskunftsersuche auszustellen und Befragungen durchzuführen. Wenn die Kommission im Anschluss weiterhin einen Verstoss vermutet, kann sie ein Verfahren eröffnen. Bevor die Kommission eine Entscheidung über die Nichteinhaltung oder die Verhängung von Sanktionen erlässt, gibt sie Anbietern die Möglichkeit, zu ihren vorläufigen Feststellungen Stellung zu nehmen. Die Kommission kann auch einstweilige Massnahmen erlassen, um das Risiko eines schweren Schadens für Nutzer zu mindern. Die Sanktionen für Verletzungen von Pflichten betragen ebenfalls bis zu 6 % des weltweiten Jahresumsatzes für schwere und wiederholte Verstösse und bis zu 1% bei geringeren Verstössen. Zudem bestehen tägliche Zwangsgelder, von bis zu 5% der durchschnittlichen Tageseinnahmen, damit Anbieter vollständige Informationen vermitteln, sowie einstweiligen Massnahmen und Verpflichtungszusagen nachkommen.

Die Kosten für die Aufsichtstätigkeit tragen im Entwurf die Anbieter, in Form einer Verfahrensgebühr und einer Aufsichtsabgabe für weitere Aufwände, die maximal 0,05% des weltweiten Gewinns im vergangenen Jahr beträgt. Die EU erhebt eine jährliche Aufsichtsgebühr, die ebenfalls maximal 0.05% des weltweiten Jahresgewinns beträgt, aber auch die Kosten für einzelne Verfahren decken soll. Die Kommission hat hierzu eine delegierte Verordnung erlassen, allerdings hat das Gericht der Europäischen Union kürzlich Klagen von TikTok und Meta gegen die Aufsichtsgebühr gutgeheissen.

Korrektur: Die erste Version dieser Analyse schrieb versehentlich, dass Betroffene nur in der Schweiz jederzeit eine Streitbeilegungsstelle angehen können. Im DSA muss allerdings nicht zuerst das interne Beschwerdeverfahren durchgeführt werden: Gemäss Erwägungsgrund 59 sollten Nutzer zwischen dem internen Beschwerdeverfahren, einer außergerichtlichen Streitbeilegung und der Möglichkeit, jederzeit Klage vor Gericht zu erheben, wählen können. Literatur und Streitbeilegungsstellen ermutigen allerdings dazu, vor der Streitbeilegung das interne Beschwerdeverfahren durchzuführen.